Mac 安装 Ollama 和 Open WebUI

2025-06-27 · 364 chars · 2 min read

这几天一直想整一个本地知识库,研究了下本地部署小模型相关的东西,顺便记录一下,不然博客就长草了......

因为我的想法是,在家里的小服务器上跑 Open WebUI 和 Dify 等服务,同时存一些文章、笔记,24 小时开着;台式机性能好,用来跑模型,随用随开。所以晚上下班前,在公司的 Mac 上试了下,Podman 里部署 Open WebUI,本地部署 Ollama。

Ollama 安装#

没有性能好的服务器,只能本地安装 Ollama,比较简单,在官网下载直接装就行。

安装完成后启动,按照提示装 cli 工具,下载模型,这里他默认推荐的 llama3.2 太弱,可以装一下 DeepSeek-R1-0528-Qwen3-8B:

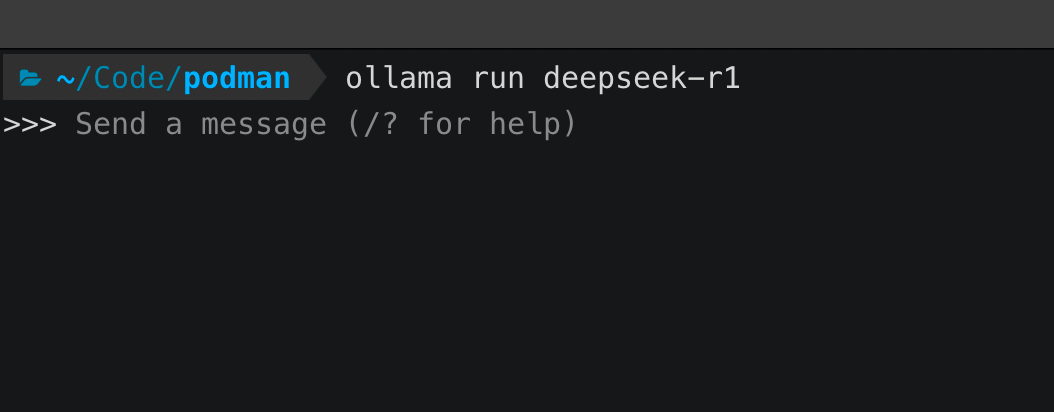

ollama run deepseek-r1

这样就能对话了,接下来在 Podman 里安装 Open WebUI。

Open WebUI 安装#

前面说了,Open WebUI 我要安装在 Podman 里,先下载镜像:

podman pull ghcr.io/open-webui/open-webui:main # 或者用 docker docker pull ghcr.io/open-webui/open-webui:main

我本地用的一些服务,都放在了 podman compose 里,所以 Open WebUI 也加进去。修改 compose.yaml 文件

services:

# 其他服务省略...

open-webui:

image: ghcr.io/open-webui/open-webui:main

container_name: open-webui

volumes:

- ./open-webui:/app/backend/data

ports:

- 3000:8080

environment:

- OLLAMA_BASE_URL=http://host.docker.internal:11434

restart: unless-stopped

这里的关键是 OLLAMA_BASE_URL=http://host.docker.internal:11434,要让 Podman/Docker 里的 Open WebUI 访问宿主机的 Ollama 服务。

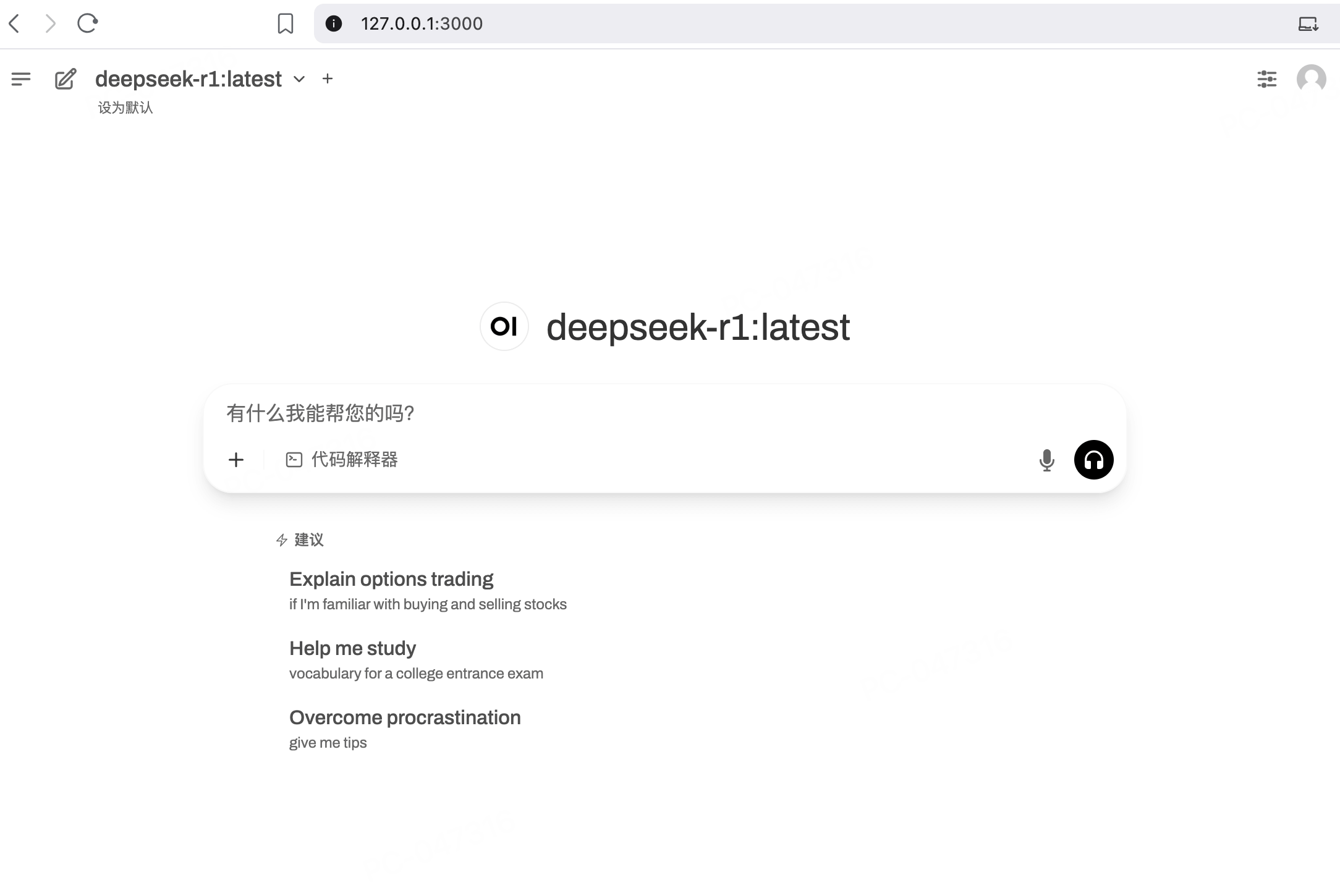

启动后,浏览器访问 http://127.0.0.1:3000 即可: